دانشمندان از کمتوجهی به ابعاد مختلف توسعهٔ هوش مصنوعی ابراز نگرانی میکنند

واهمه از «خودآگاهی» ماشینها

محققان خواستار بودجه بیشتر برای مطالعهٔ مرز بین سیستمهای خودآگاه و ناخودآگاه هستند

۶ دی ۱۴۰۲، ۲۲:۰۸

|پیام ما| آیا سیستمهای هوش مصنوعی (AI) میتوانند خودآگاه شوند؟ سه پژوهشگران خودآگاهی میگویند که در ال حاضر، هیچچیز از این موضوع نمیدانیم و بهدلیل انجام نشدن مطالعات و تحقیقاتی در اینباره، نگرانند. سه نفر از رهبران انجمن علوم آگاهی ریاضی (AMCS) در اظهارنظری خطاب به سازمان ملل متحد خواستار آن شدند که تحقیقات دربارهٔ هوش مصنوعی و خودآگاهی آن مورد حمایت بیشتری قرار گیرد. آنها میگویند که انجام تحقیقات علمی متمرکز بر شناختن مرز بین سیستمهای هوش مصنوعی خودآگاه و ناخودآگاه ضروری است. آنها بر این باورند که این مسایل اخلاقی، قانونی و ایمنی هستند که درک خودآگاهی هوش مصنوعی را بسیار مهم میکنند. بهعنوان مثال، باید بهدرستی این موضوع تشریح شود که اگر هوش مصنوعی شروع به توسعهٔ خودآگاهیاش کرد، آیا بهتر است به مردم این اجازه را بدهیم که بعد از استفاده از هوش مصنوعی، آن را از کار بیاندازند؟

«جاناتان میسون» (Jonathan Mason)، ریاضیدان مستقر در آکسفورد انگلستان که یکی از نویسندگان این نظرات است میگوید که معمولاً چنین نگرانیهایی از مباحثات رسمی دربارهٔ ایمنی هوش مصنوعی مطرح نمیشوند. مثلا در اجلاس ایمنی هوش مصنوعی که در انگلستان برگزار شد، دربارهٔ این موضوع صحبتی به میان نیامند. او همچنین یادآوری میکند که در فرمان اجرایی «جو بایدن»، رئیس جمهوری ایالات متحده که با هدف توسعهٔ مسئولانهٔ هوش مصنوعی صادر شد، مسائل مربوط به سیستمهای خودآگاه هوش مصنوعی درنظر گرفته نشد.

میسون میگوید: «با وجود همهٔ اتفاقاتی که در هوش مصنوعی درحال وقوع است، اما همیشه مسایلی جانبی دربارهٔ علم وجود دارد که ناگزیر باید به آنها توجه کرد، خودآگاهی یکی از آنهاست.»

دو نویسندهٔ دیگر این اظهارنظر، «لنور بلوم» (Lenore Blum)، نظریهپرداز حوزهٔ کامپیوتر در دانشگاه «کارنگی ملون» پنسیلوانیا و «یوهانس کلینر» (Johannes Kleiner)، ریاضیدان از دانشگاه لودیک ماکسیمیلیان آلمان بودند.

این یک داستان علمی-تخیلی نیست

اینکه آیا سیستمهای هوش مصنوعی خودآگاه وجود دارند یا اینکه آیا سیستمهای هوش مصنوعی میتوانند به خودآگاهی برسند، هنوز برای علم ناشناخته است. میسون میگوید: «حتی فهمیدن اینکه یکی از این سیستمها توانسته خودآگاهی را توسعه دهد، خودش یک چالش است. چون هنوز دانشمندان روشهای معتبر علمی برای ارزیابی خودآگاهی در ماشینها ایجاد نکرده اند.»

«رابرت لانگ» (Robert Long)، فیلسوفی است که در مرکز ایمنی هوش مصنوعی، یک سازمان تحقیقاتی غیرانتفاعی در سانفرانسیسکو امریکا فعالیت میکند. او میگوید: «با توجه به سرعت پیشرفت هوش مصنوعی، عدم اطمینان در مورد خودآگاهی هوش مصنوعی، فقط یکی از مسائل متعدد نگرانکننده دربارهٔ این فناوری است.»

چنین نگرانیهایی دیگر فقط سوژهٔ داستانهای علمی-تخیلی نیستند. شرکتهایی مانند «اوپن ایآی» (که «چت جیپیتی» را راهاندازی کرده است) با تمرکز بر آموزش یک سیستم یادگیری عمیق با هدف انجام طیف گستردهای از وظایف فکری شبیه به آنچه که انسان میتواند انجام دهد، در حال توسعهٔ هوش مصنوعی عمومی هستند. برخی محققان پیشبینی میکنند که رسیدن به هوش مصنوعی به خودآگاهی، در پنج تا ۲۰ سال آینده محقق میشود. میسون میگوید که با این وجود، از تحقیقات برای خودآگاهی سیستمها حمایت مالی بسیار کمی انجام میشود: «تا آنجا که میدانم، در سال ۲۰۲۳ حتی یک پیشنهاد کمکهزینه برای مطالعات این موضوع وجود ندارد.»

شکاف اطلاعاتی که نویسندگان این اظهارنظر مشخص کردهاند، به دست کمیتهٔ عالی مشورتی سازمان ملل متحد در زمینهٔ هوش مصنوعی رسیده است. این کمیتهٔ عالی، اکتبر امسال تشکیل شد و قرار است در میانهٔ سال ۲۰۲۴ گزارشی را در مورد چگونگی مدیریت فناوری هوش مصنوعی در جهان منتشر کند. این اظهارنظر بهصورت عمومی منتشر نشده است اما کمیتهٔ عالی به انجمن علوم آگاهی ریاضی این اطمینان را داده است که اظهارنظر آنها، بخشی از «مفاد اساسی» گزارش کمیته خواهد بود، یعنی اسنادی که قرار است توصیههایی دربارهٔ نظارت جهانی بر سیستمهای هوش مصنوعی ارائه دهند.

محققان انجمن علوم آگاهی میگویند که برای ارزیابی پیامدهای خودآگاهی هوش مصنوعی برای جامعه، این ضروری است که درک کنیم چهچیزی میتواند هوش مصنوعی را خودآگاه کند. انسان باید ارزیابی کند که آیا چنین سیستمهایی برپایهٔ ارزشها و منافع انسانی کار میکنند. در غیر اینصورت، آنها میتوانند برای مردم ایجاد خطر کنند.

نیازهای ماشین

از طرف دیگر محققان میگویند که انسان باید نیازهای احتمالی هوش مصنوعی خودآگاه را نیز درنظر بگیرد. مثلا این را بدانند که آیا این سیستمها میتوانند رنج ببرند؟ لانگ میگوید: «اگر نتوانیم خودآگاه شدن یک سیستم هوش مصنوعی را تشخیص دهیم، ممکن است به یک موجود خودآگاه، بدون اینکه بدانیم تحمیل درد کنیم. ما در گسترش توجه اخلاقی به موجوداتی که شبیه ما نیستند، واقعاً سابقهٔ خوبی نداریم.» به گفتهٔ او، خطا در نسبتدادن خودآگاهی نیز مشکلساز خواهد بود، چون انسان نباید منابع محدود خود را برای محافظت از سیستمهایی که نیازی به حفاظت ندارند صرف کند.

برخی از سوالات مطح شده در اظهارنظر رهبران انجمن علوم آگاهی، برای برجستهکردن اهمیت قانونی مسئلهٔ خودآگاهی است. بهعنوان مثال «آیا یک سیسم هوش مصنوعی خودآگاه باید برای عمل عمدی اشتباه خود پاسخگو باشد؟» یا «آیا باید حقوقی برابر با مردم داشته باشد؟» پاسخ به این سوالها ممکن است نیازمند تغییر در قوانین و مقررات موجود باشد.

از سوی دیگر برای آموزش افراد غیرمتخصص، به دانشمندان حوزهٔ هوش مصنوعی احتیاج داریم. همچنانکه شرکتها، سیستمهای هوش مصنوعی را با پیچیدگی و توانمندیهای بیشتر طراحی میکنند و توسعه میدهند، طبیعی است که مردم بخواهند بدانند که آیا این سیستمها دارای خودآگاهی هستند یا خیر. در اینجا دانشمندان این حوزه برای ارائه راهنمایی به مردم، باید به اندازهٔ کافی در این مورد بدانند.

علاوه بر سه نفر رهبر انجمن علوم آگاهی، سایر پژوهشگران این حوزه نیز همین نگرانیها را بیان میکنند. «سوزان اشنایدر» (Susan Schneider)، فیلسوف و مدیر مرکز «ذهن آینده» در دانشگاه فلوریدا آتلانتیک میگوید که چتباتهایی مانند چتجیپیتی در رفتارهای خود بسیار شبیه به انسان بهنظر میرسند و طبیعتاً مردم در برخورد با آنها بهاشتباه میافتند. بدون تجزیه و تحلیل دقیق توسط دانشمندان، ممکن است برخی افراد به این نتیجه برسند که چنین سیستمهایی خودآگاه هستند در حالی که سایر اعضای جامعه نگرانیهای مربوط به خودآگاهی هوش مصنوعی را رد کنند یا به دیدهٔ تمسخر به آنها نگاه کنند.

برای کاهش خطرات احتمالی، رهبران انجمن علوم آگاهی از دولتها و بخش خصوصی میخواهند تحقیقات بیشتری دربارهٔ خودآگاهی هوش مصنوعی انجام دهند. آنها میگویند برای پیشبرد این تحقیقات، بودجهٔ زیادی لازم نیست و تا به امروز، با وجود حمایتهای محدود این کار در حال انجام است. مثلا لانگ و ۱۸ پژوهشگر دیگر چکلیستی از معیارهای ارزیابی سیستمها را توسعه دادهاند که برای دریافتن این نکته که کدام سیستم شانس بالایی برای رسیدن به خودآگاهی دارد، بهکار میآید. میسون میگوید: «دتانسیل زیادی برای پیشرفت این مباحث وجود دارد.»

منبع:

*متن اصلی این گزارش با عنوان AI consciousness: scientists say we urgently need answers روز اول دیماه در «نیچر» منتشر شده است.

پیشنهاد سردبیر

مطالب مرتبط

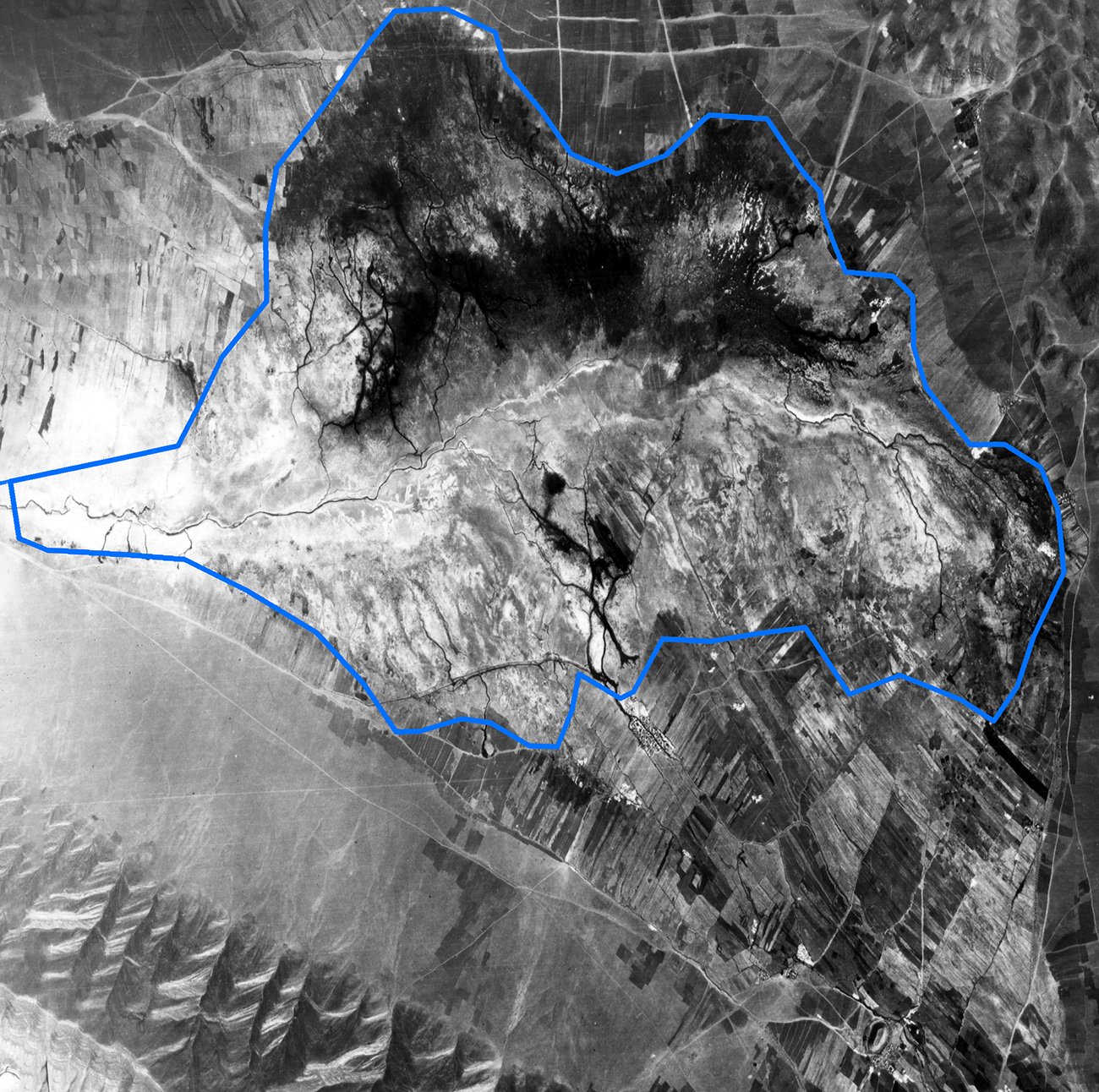

«پیام ما» از مقاومت ادارۀ کل محیطزیست استان چهارمحالوبختیاری در مقابل سایر نهادهای استانی برای تصاحب اراضی تالابی گزارش میدهد

سودای مسکنسازی در تالاب «خانمیرزا»

گردوغبار بیش از ۶۰۰ نفر را روانهٔ بیمارستان کرد

تداوم توفان غبار در سیستان

«پیام ما» وعدههای «سعید جلیلی» در حوزۀ آب و کشاورزی را بررسی کرد

گشادهدستی از جیب «آب» کشور

چرا در «سوادکوه» سیلاب آمد و برای جلوگیری از تکرار آن چه باید کرد؟

هفت متهم سیل ویرانگر

هیئت وزیران برای افزایش میزان تولید بنزین، «تولید بنزین با کیفیت معمولی» را تصویب کرد

چراغ سبز به تولید بنزین بیکیفیت؟

آیا خشکسالی دو سال دیگر تمام میشود؟

نگاهی به یک مقاله علمی دربارهٔ آلودگی هوای کلانشهر تهران

در جستوجوی نسخه شفابخش آلودگی هوا

فعالان محیطزیست لرستان از بیجوابماندن نامهشان دربارۀ توقف جادهکشی در اشترانکوه از سوی سازمان محیطزیست گلایه دارند

تخریب گَهَر، ویرانی اشترانکوه

صدای اکثریت چراغ راهنمای اصلاح

مرگ خاموش دریاچۀ گهر و اشترانکوه

نظر کاربران

نظری برای این پست ثبت نشده است.

تبلیغات

وب گردی

- محبوبترین تورهای ترکیه کدامند؟

- حداقل سرمایه برای واردات از دبی: آنچه باید بدانید

- چطور زودتر از همه از پیش فروش قطارها مطلع شویم؟

- چه کسانی نمی توانند مهاجرت کنند؟

- تفاوت رهگیری مالیاتی و کد مالیاتی چیست؟

- نوآوریهای جدید تتر در ارائه خدمات مالی دیجیتال

- عمر باتری آیفون 15 پرو مکس در مقابل سامسونگ اس 24 اولترا

- دوره mba و dba مرکز آموزش های آزاد دانشگاه تهران

- آینده واردات عروسک و اسباب بازی از چین به ایران، پیشبینی و ترندها

- قطار رجا؛ انتخابی امن و راحت برای سفرهای شما بیشتر

بیشترین نظر کاربران

«آفاق آزادی در سپهر تاریخ» در غیاب زیباکلام

بیشترین بازنشر

پربازدیدها

1

به نام حیوانات به کام باغوحشداران

2

«بمو» را تکهتکه کردند

3

سوداگران گنج پل تاریخی ۳۰۰ ساله در بابل را تخریب کردند

4

محیطبانها با رد زنی چرخهای موتورسیکلت به شکارچیان رسیدند

5

کبوتر نماد مناسبی برای صلح است؟

دیدگاهتان را بنویسید